ここ最近の研究ではディープラーニングの高速化が流行っていて、iOSでもデバイス上の演算で実用的なスピードが実現されつつあります。

自分が約一年前にディープラーニングを使って映像作品を作った時はどえらい大変でしたが、今や手のひらの上でできちゃうんですから。進化スピードがムーアの法則どころではない!

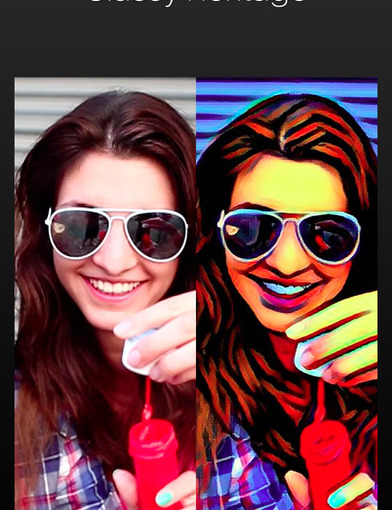

数ヶ月前に話題になったのが「Prisma」という写真アプリ。

これは同技術を使ってデバイス上で手軽に絵画風に変換できるもの。

有名ドコロの絵師のスタイルを模倣できます。

やったもんがち早い者勝ち感の強いアプリですね。

アプリの作りもオシャレな仕上がりで、Instagramユーザをターゲットにしているような感じです。

静止画の次は動画

そして、時間の問題だとは思ってましたが、出ました。動画です。

それが「Aristo」

実際に使ってみたけど、Prismaより少し画質が荒いかな?と感じるぐらいで、スピードは結構速い。

FPSが低いので多少のカタカタ感はありますが、これもそのうち改善されるでしょう。

それにしてもPrismaとくらべて感じるのは「デザイナー不在感」。

アプリのアイコンがダサすぎる・・。

UIも飾りっけが無くてなんか寂しい。

おそらくその辺もわきまえた会社が別のアプリを出しそうな予感がします。

いずれにせよ、どんどんディープラーニングが日常に浸透してきていてワクワクしますね!